Hallo Thomas, magst Du Dich und dtms kurz vorstellen?

Mein Name ist Thomas Lang und ich bin seit 2016 CEO von dtms. Nach 10 Jahren Erfahrung als Berater und Unternehmer bin ich in die Telekommunikationsbranche eingestiegen und auf der Suche nach einer neuen Herausforderung dann auf dtms gestoßen – oder sie auf mich. Die dtms ist als Kundenservice-Spezialist schon seit 20 Jahren im Markt. Ich stand vor der Herausforderung ein mittelständisches Unternehmen aus dem interessanten Spezialbereich Telekommunikation und Cloud neu auszurichten, zu digitalisieren und eben auch in die Zukunft zu führen – das war genau das, worauf ich Lust hatte.

Im Rahmen dieser Zukunftsausrichtung arbeitet Ihr auch mit KI und Chatbots – wie kam es zu der Entscheidung?

In Kontakt-Centern macht der Call, neben der E-Mail, noch immer den wichtigsten Anteil aus. Die dtms hat angefangen sich näher mit diesem Thema zu beschäftigen und die Situation in Callcentern analysiert. Dabei haben wir festgestellt, dass die Kunden heutzutage mehr und vor allem schnellere Kommunikationskanäle von Unternehmen erwarten. Niemand möchte stundenlang in Warteschleifen hängen oder tagelang auf die Beantwortung einer E-Mail warten. Auf der anderen Seite stehen die Callcenter natürlich auch unter enormem Kostendruck und können es sich nicht leisten mehr Agenten einzustellen. Da haben wir uns gefragt, wie wir die Anfragen möglichst effizient und kanal-agnostisch beantworten können. So kamen wir auf die Idee eine KI zu entwickeln.

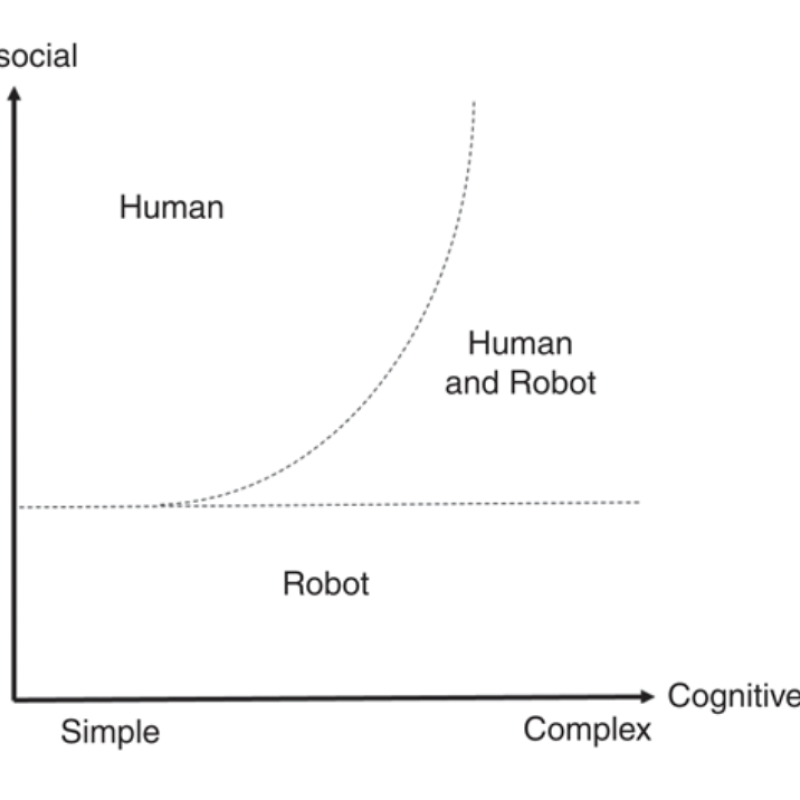

Das klingt spannend. Lösen die Bots die realen Agenten in Zukunft ab?

Ganz so leicht ist das nicht. Die Bots kommen immer dann zum Einsatz, wenn es um einfache Anfragen geht, bei denen keine soziale Intelligenz oder das Lösen einer multiplen Problemsituation nötig ist. Diese sogenannten Standardanfragen machen mit bis zu 70% den Großteil aller Anfragen in Callcentern aus. Mit Hilfe von KI können diese Standardanfragen automatisiert beantwortet werden und befinden sich dank eines definierten Confidence-Levels auch auf einem hohen Qualitätsniveau. Die verbleibenden Agenten werden dann eingesetzt, wenn es zu komplizierteren Anfragen kommt oder man beispielsweise auf verärgerte Kunden persönlich zugehen muss. Das ist unser Modell des hybriden KI-Agenten: Während sich die KI um den Standard kümmert, können sich die Agenten auf die wertschöpfenden Teile der Arbeit konzentrieren.

Du hast gerade von einem Confidence-Level gesprochen. Was ist das genau?

In unserem Modell rechnet die KI aus, wie wahrscheinlich sie die richtige Antwort auf eine Frage kennt. Diese Wahrscheinlichkeit nennen wir Confidence-Level. Der Kunde kann dann entscheiden, ab welchem Level eine Antwort ausgespielt werden soll. Liegt die Wahrscheinlichkeit unter der angegebenen Vorgabe für den Kunden, dann wird die Frage automatisch an einen Agenten weitergeleitet. Es ist nicht schlimm, wenn die KI eine richtige Antwort zwar gewusst hätte, das Confidence-Level aber zu niedrig gesetzt wurde. Fataler ist jedoch der sogenannte False-Positive-Case – wenn also eine Antwort von der KI als richtig benannt wird, sie in Wahrheit aber falsch ist.

Wie geht Ihr vor, wenn ein neuer Kunde auf Euch zukommt?

Wir beginnen neue Kundenprojekte meist mit einer Workshop Phase, bei der zunächst die Ausgangslage neutral analysiert wird. Daraufhin wird entschieden ob und welche Form von Künstlicher Intelligenz im Use Case sinnvoll ist – bevor wir mit dem Training beginnen. Es gibt auf dem Markt natürlich auch viele Anbieter, die nur das Training der KI Instanzen übernehmen – der ganze Bereich befindet sich gerade noch in einer Findungsphase. Ich glaube, dass die MUUUH! Group in diesem Zusammenhang einen sehr guten Ansatz verfolgt: Die Idee mit einem Framework dem Kunden anbieterübergreifend eine optimale Struktur zur Verfügung zu stellen. Ihr seid da im Grunde ein neutraler Agent im Sinne des Kunden und schaut, dass ihr jeweils die besten Lösungen findet. Und wir sehen das genauso. Ich habe auch schon Projekte abgelehnt, bei denen ich dachte, dass wir es nicht leisten können oder es nicht zu uns passt.

Mit welchen Herausforderungen werdet Ihr bei Eurer täglichen Arbeit konfrontiert?

Auf dem aktuellen Stand der KI Entwicklung ist es schwierig dem Kunden zu vermitteln, dass er hohe Beträge für Systeme bezahlt, die sich erst nach 1-3 Jahren refinanziert haben. Zukünftig wird das Thema KI einen riesigen Impact haben, aber im Moment müssen wir über kleinere E-Mail- und Chatbot-Projekte oder FAQ Bots an die Unternehmen herangehen, um sie langsam mit dem Thema vertraut zu machen.

Wir sind außerdem der Meinung, dass sich die KI irgendwann auf alle Kommunikationskanäle beziehen muss. Chatbots sind nur eine Ausprägung in einem bestimmten Kanal. Die Intelligenz, die Software, aber vor allem die Knowledge Database hinter dem Chatbot muss für alle Kanäle aufgebaut werden.

Habt Ihr einen besonderen Use Case, von dem Du uns berichten kannst?

Die Zusammenarbeit mit DocMorris ist ein gutes Beispiel. Das ist unser erster Kunde, mit dem wir vor zwei Jahren eine Partnerschaft eingegangen sind. Der Kunde hatte zu der Zeit gerade relativ viele Anfragen und brauchte eine effiziente Lösung.

Bei DocMorris haben wir mittlerweile eine KI Instanz implementiert, die unter anderem im E-Mail Routing arbeitet. Hier ein Beispiel: Bei diesem Kunden handelt es sich um eine Versandapotheke, die im Bereich der nicht rezeptpflichtigen Medikamente häufiger Stornierungen erhält, da sich die Patienten inzwischen anders versorgt haben. Wenn ein bestelltes Produkt verpackt ist, kann es aber nicht mehr zurückgenommen werden und muss vernichtet werden – das ist sehr kostspielig. Wir haben ein System entwickelt, dass eine Stornierung automatisch identifiziert und sie umgehend an die Logistik weitergibt. Dort wird das Paket dann gar nicht erst produziert bzw. frühzeitig abgefangen. Das spart eine Menge Geld. Wir haben das System auf E-Mail Kategorisierung und Beantwortung weiterentwickelt und mittlerweile auch um das Thema Chat ergänzt.

Zu guter Letzt: Gibt es etwas Neues, woran Ihr gerade arbeitet?

Wir beschäftigen uns unter anderem zurzeit mit dem Thema Voice. Dabei planen wir jedoch keine eigene Voice Recognition zu entwickeln – dafür gibt es schon zu viele gute Systeme. Wir testen gerade mehrere bestehende Systeme und schauen welches sich für eine vernünftige Speech-zu-Text und Text-zu-Speech Conversion eignet. Wir arbeiten an der Integration einer der führenden Spracherkennungssysteme in unser System und werden diese Lösung auch auf der nächsten CallCenterWorld-Messe 2019 präsentieren.

Denn erst wenn wir Automatisierung bei der gleichbleibenden Menge von Calls einsetzen, werden die Contact Center nachhaltig entlastet.

Vielen Dank, Thomas!

Für klassische Callcenter gewinnen die Themen Künstliche Intelligenz und digitale Agenten immer mehr an Bedeutung. Doch was können Conversational User Interfaces im heutigen Zeitalter von KI und Machine Learning wirklich leisten und was noch nicht? In unserem kostenlosen Whitepaper erklären wir anschaulich, wie Chatbots arbeiten und wie moderne Machinelearning Algorithmen die Bots immer weiter verbessern.